No último conteúdo trouxe os detalhes dos modelos de linguagem como LLM e o NLP. Nesse sentido, entendemos que eles criam uma base poderosa para que as empresas entreguem não apenas resultados, mas também experiências sob medida para cada usuário.

No entanto, vivemos um ciclo acelerado de evolução em que, mesmo os LLMs mais avançados, ainda enfrentam um desafio central: como fornecer respostas precisas e atualizadas sem depender apenas do que foi aprendido durante o treinamento?

Essa é uma limitação importante, pois quando precisam lidar com informações recentes ou muito específicas, esses modelos podem apresentar falhas ou gerar respostas incompletas.

É por isso — e por outras razões — que vamos apresentar um aliado capaz de fortalecer esses processos. Vem comigo!

A solidez das informações é a essência do RAG

Foi justamente para resolver esse desafio que surgiu o Retrieval-Augmented Generation (RAG).

Essa abordagem conecta o poder de raciocínio dos modelos com a capacidade de consultar dados externos em tempo real.

Em vez de depender apenas da memória do treinamento, o modelo busca informações em bases atualizadas, como documentos, artigos, relatórios ou bancos de conhecimento.

Basicamente, o RAG usa esse material como referência antes de gerar a resposta.

Na prática o pavimento das respostas se torna mais confiáveis, contextualizadas e baseadas nas informações mais recentes disponíveis, aproximando a inteligência artificial de um uso realmente hábil em cenários de negócios, pesquisa e inovação.

Leia também:

A inteligência artificial que resolve problemas crônicos nas empresas

Dados & IA: transforme dados em insights acionáveis

O RAG agora é quem dita o jogo

Olhando pelo prisma dos Modelos tradicionais de linguagem temos à disposição enciclopédias estáticas.

Eles sabem muito, mas apenas sobre o que foi incluído no seu treinamento.

Se uma informação muda ou um fato novo surge, o modelo não consegue acessá-lo, a menos que seja retreinados, um processo caro, demorado e muitas vezes inviável em escala corporativa.

No idioma da gestão isso é inviável!

Em contrapartida, o RAG resolve essa limitação integrando duas etapas fundamentais.

Primeiro, ele recupera informações relevantes de uma ou mais fontes externas. Depois, utiliza essas informações como contexto para gerar a resposta final.

Esse simples acoplamento muda a natureza da interação: em vez de confiar apenas na memória do modelo, passamos a ter um sistema que consulta antes de responder.

Pense no funcionamento, como um colaborador que, antes de tomar uma decisão, acessa manuais, relatórios e documentos atualizados.

Ele não substitui a inteligência do modelo, mas amplia sua capacidade de estar sempre alinhado ao estado mais recente da informação, entende!?

Do beabá à prática: o funcionamento do RAG

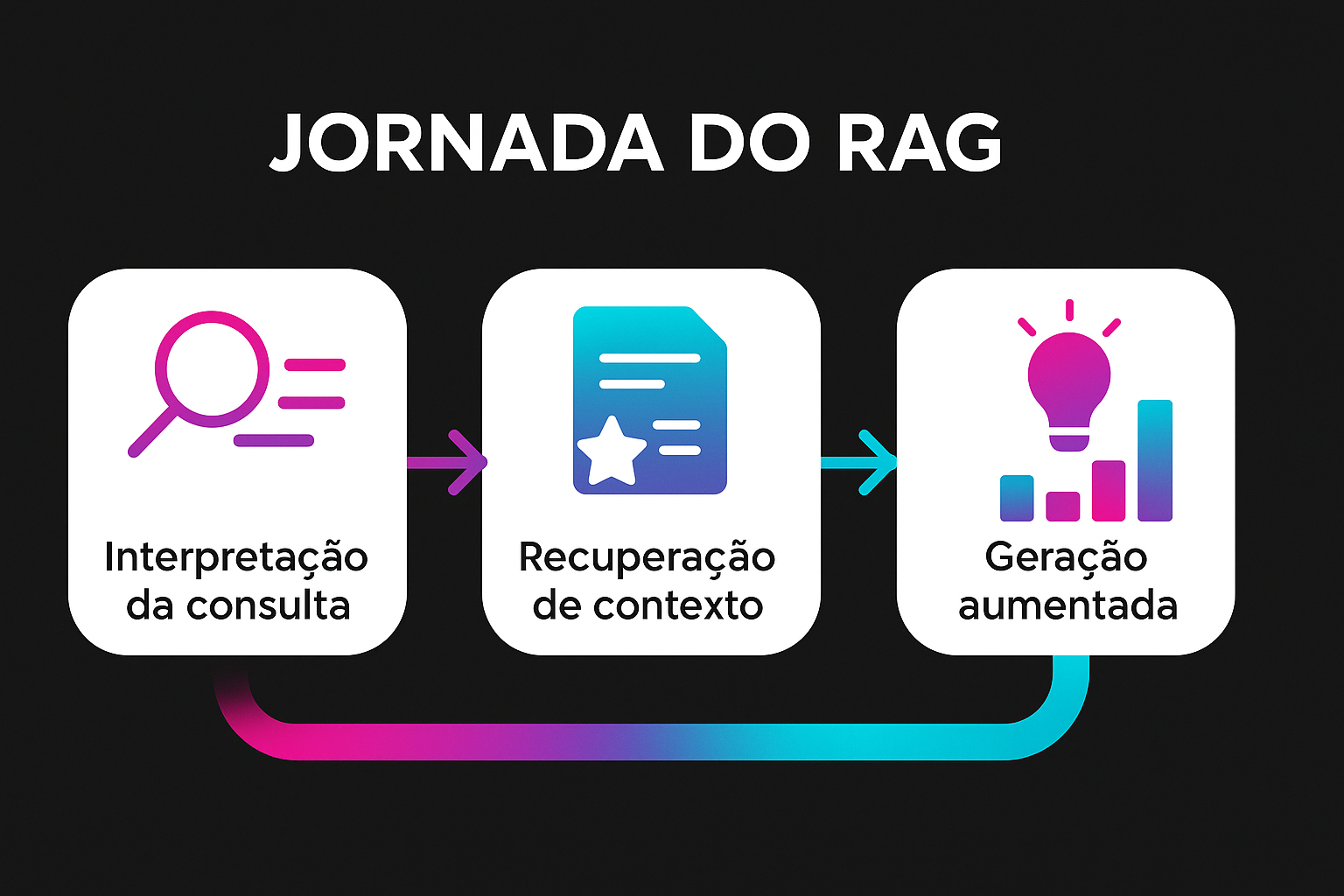

A jornada de dinamicidade do RAG começa em um fluxo básico, envolvendo três etapas principais:

Interpretação da consulta

Nessa fase, o modelo entende a pergunta do usuário e extrai os elementos-chave.

Recuperação de contexto

Aqui, esse mecanismo de busca especializado localiza documentos ou trechos relevantes em bases de conhecimento internas ou externas.

Geração aumentada

O LLM recebe essas informações e as utiliza para compor uma resposta contextualizada e coerente.

Dito isso, destaco essa abordagem particularmente útil em cenários onde a informação muda rapidamente ou onde a precisão factual é crítica, como em suporte técnico, jurídico ou científico.

Para compreender:

Pense que ao perguntar sobre um produto em uma central de atendimento, o RAG não se limita ao que sabe de forma genérica.

Mas vai além, ele busca a documentação técnica mais recente, os manuais de instalação, os inúmeros registros de chamados anteriores e até políticas de garantia antes de elaborar a resposta.

Esse mix de interações, traz ao enredo da operação um atendimento mais preciso, rápido e consistente.

O RAG está mais presente do que imaginamos!

Se alguém ainda acha que essa inovação é exclusivamente técnica, está enganado, pois o RAG está mudando a forma como diferentes setores lidam com informação crítica e atualizada. Confira!

Da consulta médica à decisão mais segura

Na área da saúde, um detalhe desatualizado pode custar caro. Por esse motivo, o RAG cria a sinergia com sistemas de apoio para consultar protocolos clínicos recentes antes de sugerir diagnósticos ou tratamentos.

Uma interação que vem ajudando médicos a tomarem decisões mais seguras e pacientes a receberem cuidados mais confiáveis.

Do relatório estático ao investimento em tempo real

No setor financeiro, análises baseadas em relatórios antigos já não bastam.

Ao lado do RAG, os assistentes de investimento acessam dados e relatórios atualizados em tempo real, oferecendo recomendações que refletem o que está acontecendo no mercado naquele exato momento.

Da pesquisa manual ao parecer fundamentado em segundos

No universo jurídico, os advogados gastam horas vasculhando jurisprudência e documentos.

Por outro lado, conectados ao RAG, eles aceleram esse processo ao recuperar precedentes relevantes em segundos, permitindo pareceres e peças mais rápidas, completas e embasadas.

Do atendimento genérico à resposta que resolve

No suporte ao cliente, respostas automáticas muitas vezes soavam vagas.

Imersos no habitat do RAG, os agentes virtuais consultam manuais, FAQs e históricos de chamados, entregando soluções exatas, consistentes e com menos tempo de espera.

Da manutenção corretiva à prevenção inteligente

No setor industrial, a rotina era consertar apenas quando a falha já tinha ocorrido.

Já com o Retrieval-Augmented Generation (RAG), isso tudo é aprimorado ao combinar históricos de falhas e catálogos de peças em tempo real, antecipando problemas e evitando paradas inesperadas.

Diante dessas incontáveis vantagens, destaco mais outras como:

- Precisão aprimorada, já que cada resposta é fundamentada em fontes verificáveis.

- Atualização contínua, sem depender de reentrenamentos longos e custosos.

- Capacidade de lidar com perguntas de nicho, aproveitando bases especializadas.

- Escalabilidade, permitindo que múltiplos agentes consultem dados sem sobrecarregar a TI.

- Transparência, com a indicação clara de quais documentos serviram de base.

Desafios e cuidados necessários

Se por um lado o RAG amplia a precisão e a atualização das respostas, por outro ele herda a responsabilidade da qualidade das fontes consultadas.

Portanto, bases desatualizadas, inconsistentes ou mal estruturadas podem comprometer todo o processo, entregando respostas equivocadas.

Além disso, um fator de grande atenção é a performance, afinal, a recuperação de dados precisa ser rápida, sob risco de transformar a promessa de agilidade em frustração para o usuário.

Nesse ponto, a arquitetura da solução faz toda a diferença.

Também entram em cena as questões de governança de dados. Em ambientes corporativos, muitas vezes os repositórios contêm informações sensíveis.

Nesse sentido, é essencial a definição de regras de acesso, bem como a aplicação de anonimização quando necessário e manter trilhas de auditoria para evitar riscos de compliance e vazamentos.

Por fim, há o desafio cultural. Para que o RAG seja realmente adotado, as equipes de negócio precisam confiar nas respostas geradas.

Isso exige transparência sobre como as informações foram buscadas e utilizadas, criando segurança de que a tecnologia não é uma “caixa-preta”, mas uma ferramenta auditável e confiável.

Por que isso importa agora?

Você sabe. nunca se produziu tanta informação em tão pouco tempo.

A cada segundo, novos dados, relatórios e descobertas surgem em escala exponencial. Dito isso, depender de modelos “congelados” no momento do treinamento deixa de ser suficiente.

O que para setores críticos, como bancos, hospitais ou companhias de energia trabalhar com dados obsoletos não é apenas ineficiente: é arriscado.

É aqui que o Retrieval-Augmented Generation (RAG) marca a diferença. Ele combina a inteligência acumulada nos modelos com a capacidade de buscar e integrar novos conhecimentos em tempo real.

Em outras palavras, aproxima a IA de um comportamento mais humano: consultar antes de decidir. Isso abre caminho para interações mais precisas, decisões mais informadas e processos muito mais eficientes.

Leia também:

Cloud native: o que é e quais são os principais benefícios?

Por que migrar para a nuvem? Descubra 3 bons motivos

O que são serviços gerenciados em nuvem?

Do presente ao futuro competitivo

O futuro da interação entre pessoas e máquinas será moldado por tecnologias como o RAG. Não se trata apenas de respostas melhores, mas de relações mais confiáveis entre empresas, clientes e parceiros

Na corrida pelo mercado, vencerá quem tiver coragem de ir além da atmosfera do óbvio. É hora de atualizar sua empresa para a versão mais competitiva da IA.

A Wevy pode ajudar você a dar esse próximo passo!